Aufgaben und Funktionsweise von Suchmaschinen

Bevor wir uns konkret mit den Instrumenten der Suchmaschinenoptimierung auseinandersetzen, ist es notwendig, die Suchmaschinen selbst und ihre Funktionsweise näher zu betrachten. Erst nach diesem Grundverständnis sind wir in der Lage, genauere Strategien für eine erfolgreiche SEO abzuleiten und für ein Unternehmen umzusetzen.

Dabei konzentrieren wir uns im weiteren Verlauf dieses Studienskripts vor allem auf die Suchmaschine Google®. Laut dem Statistikportal statista® (Quelle: (statista(R), https://de.statista.com/statistik/daten/studie/222849/umfrage/marktanteile-der-suchmaschinen-weltweit/, Datum des Abrufs: 29.08.2023)) erreichte Google® im Juli 2023 einen durchschnittlichen Marktanteil von ca. 83,49% bei der Desktop-Suche und sogar ca. 96% bei der mobilen Suche.

Andere wichtige Suchmaschinen wie Bing®, Yandex® oder Baidu® arbeiten nach ähnlichen Prinzipien und werden ebenfalls in die SEO-Strategie einbezogen, sofern eine internationale Ausrichtung erforderlich ist (Yandex® für Russland, Baidu® für China).

Eine Suchmaschine kann mit einer riesigen Datenbank verglichen werden, die Milliarden von Webseiten und Webinhalten wie Bilder, Videos oder Dokumente in ihrem Index speichert. Wenn eine neue Website online geht und sich zum ersten Mal bei einer Suchmaschine anmeldet, wird sie zunächst einem sogenannten „First Crawl“ unterzogen.

In diesem ersten Durchlauf werden eine neue Website und ihre Inhalte sowie Links zunächst nur rudimentär indexiert. In einem zeitversetzten zweiten Durchlauf, dem so genannten „Deep Crawl“, werden weitere (restliche) Inhalte der Webseite erfasst und gespeichert. Bei beiden Crawls erfassen Suchmaschinen nur die für sie technisch lesbaren Inhalte.

Um diejenigen Web- bzw. Unterseiten zu ermitteln, die bereits von Suchmaschinen erfasst und im Datenpool gespeichert wurden, wird im entsprechenden Suchfeld der Suchmaschine das Suchkonstrukt „site:URLderWebseite“ verwendet. Als Ergebnis werden alle Webseiten einer Site angezeigt, die bereits für die öffentliche Suche verfügbar sind.

Auf Basis dieser gespeicherten Daten erfolgt eine erste Positionierung der einzelnen Webseiten. Ab dem Zeitpunkt der Indexierung sind die Webseiten bereits über entsprechend relevante Suchbegriffe auffindbar. Die Position, an der Webseiten in den Suchergebnissen angezeigt werden, hängt von verschiedenen Faktoren ab, die einer Gewichtung unterzogen werden, wie u.a. dem Inhalt, den Keywords, verschiedenen sogenannten „Meta-Tags“, der Struktur der Webseite, der Qualität, der Ladegeschwindigkeit, dem Alter sowie bereits vorhandenen Backlinks. Um neuen Webseiten eine faire Chance auf ein erstes gutes Ranking zu geben und den Wettbewerb mit konkurrierenden Webseiten zu erhalten, werden diese nach dem First Crawl zunächst höher positioniert, als es ihre Suchmaschinenpopularität zunächst zulässt.

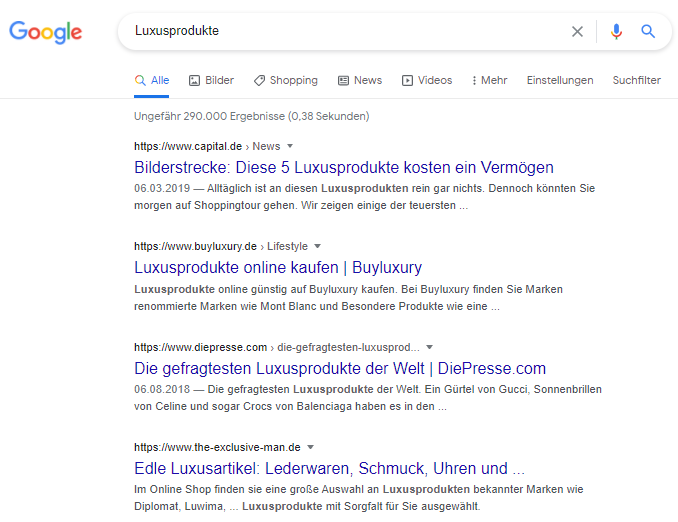

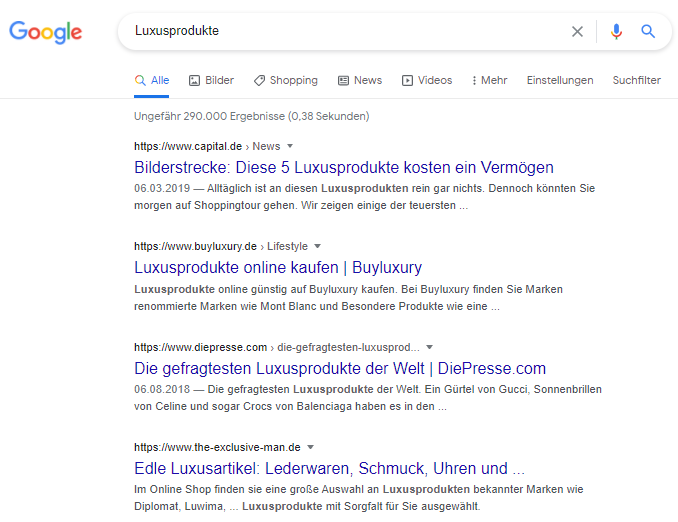

Neben den Datenbanken verfügen Suchmaschinen über ein Frontend, das ein entsprechendes Suchformular sowie die Ausgabe der Suchergebnisse bereitstellt. Hier werden die für eine Suchanfrage relevanten Suchergebnisse in Echtzeit angezeigt bzw. aufgelistet.

Abbildung 1: Darstellung des Frontend einer Suchmaschine am Beispiel von Google®. (Quelle: (Google(R) Ireland Limited, google.de. Abruf/Screenshot: 28.08.2023))

Während des Bestehens einer Website wird diese in regelmäßigen Abständen von Suchmaschinen-Crawlern, auch „Bots“ oder „Spider“ genannt, erneut besucht – abhängig von Faktoren wie Aktualisierungshäufigkeit, neuen Backlinks, neuem Content, Verbesserung der Linkstruktur und technischen Aspekten. Grundsätzlich arbeiten die Crawler unterschiedlich, d.h. die Zeitzyklen der Aktualisierungshäufigkeit und die Crawl-Tiefe der Verlinkungen variieren je nach Popularität einer Webseite und ihrer Unterseiten.

Je nach Positionierung einer Webseite wird diese von Suchmaschinen als mehr oder weniger wertvoll eingestuft.

Bei Änderungen an einer Webseite werden alte Dateien zunächst im Cache gespeichert und im späteren Verlauf überschrieben.

Betrachten wir im nächsten Schritt den Prozess einer Suchanfrage bis hin zur Ausgabe der entsprechenden Suchergebnisse.

Sobald ein Besucher eine Suchanfrage zu einem bestimmten Stichwort startet, durchsuchen Suchmaschinen innerhalb kürzester Zeit ihre indexierten Webseiten, um die Anfrage zu beantworten.

Dazu vergleichen sie den Suchbegriff mit den im Index gespeicherten Daten, errechnen für jede Webseite deren Übereinstimmung und inhaltliche Relevanz zum Suchbegriff und geben die entsprechenden Ergebnisse als sortierte Liste im Frontend aus. Die Reihenfolge der Platzierung (Ranking) der passenden Webseiten hängt neben der inhaltlichen Übereinstimmung mit dem Suchbegriff von weiteren Faktoren, wie den eingebundenen Meta-Tags, dem Alter einer Domain, der Anzahl interner und externer Links, der Qualität der Webseite sowie deren Popularität und Aktualisierungshäufigkeit ab.

Suchmaschinen passen ihre Suchalgorithmen kontinuierlich und in unregelmäßigen Abständen an, um auf neues Suchverhalten der Nutzer und Trends zu reagieren. Zu den wichtigsten Updates von Google® zählen beispielsweise Hummingbird, Penguin, Panda (vgl. (https://www.barkweb.co.uk/blog/guide-to-panda-penguin-and-hummingbird, Datum des Abrufs: 29.08.2023)), Core Update, Web Vital Update und RankBrain Update, die sich unterschiedlichen Disziplinen widmen. Viele der genannten Updates werden im Vorfeld kommuniziert, so dass eine entsprechende frühzeitige Anpassung erfolgen kann, andere werden im Hintergrund gestartet und erst nach der Implementierung veröffentlicht.

Die Folgen solcher Updates resultieren nicht selten in einer Verschlechterung der Rankingpositionen, so dass entsprechende Optimierungsmaßnahmen zwingend erforderlich sind. Im Rahmen der Suchmaschinenoptimierung ist es daher notwendig, frühzeitig auf entsprechende Updates zu reagieren.